La scarsa qualità dei dati costa – in media – alle aziende una cifra variabile tra 10 e 15 milioni di dollari annui (12,9 milioni secondo l’ultima stima Gartner nel 2021), cifre destinate ad aumentare con l’aumento della complessità del business e dei sistemi informativi.

Soltanto negli Stati Uniti, gli errori nei dati hanno un effetto negativo sull’economia pari a 3,1 miliardi di dollari l’anno, avvertiva una stima IBM del 2016, con gravi conseguenze come la mancata produttività, l’indisponibilità dei sistemi informatici e i costi di manutenzione più alti. E in molti casi (60% dei rispondenti) le organizzazioni non riescono nemmeno a fornire un numero sugli impatti finanziari del fenomeno, perché – come emerge da un’indagine Gartner – non ne misurano le conseguenze sul proprio bilancio. Una cattiva data quality crea esternalità negative a cascata, ad esempio è la prima causa di fallimento per i progetti di advanced analytics, sottolinea un’indagini degli Osservatori Digital Innovation del Politecnico di Milano.

Irion stessa è nata (nel 2004) per rispondere alle esigenze di qualità dei dati del settore bancario e assicurativo, ma poi è diventata molto di più: una piattaforma end-to-end in grado di ottimizzare ogni processo di data management, combinando varie funzionalità per creare infinite soluzioni basate sui dati, su misura e a partire dalle esigenze di qualsiasi business. Quasi 20 anni di sfide, oltre 360 Data App create e messe in produzione. Quali sono i più comuni ostacoli al successo di un progetto di data quality? Vediamo cinque situazioni piuttosto comuni e come evitarle.

Partire con obiettivi incerti o non misurabili

Ambiguità, mancata chiarezza, assenza di KPI e KQI dedicati e calcolabili ovvero una scarsa cura nel definire in anticipo le metriche fondamentali per valutare i risultati futuri. È una tendenza trasversale, in molte organizzazioni e in ogni settore. Ogni business goal dovrebbe essere formulato in ottica S.M.A.R.T. (specific, measurable, attainable, relevant, timely) quindi specifico, misurabile, raggiungibile, rilevante e inquadrato in un lasso di tempo ben definito.

Partire troppo tardi o con risorse insufficienti

Le cifre menzionate dovrebbero spiegare l’urgenza della prevenzione, anche per motivi monetari. Proprio come avviene per la nostra salute. Intervenire su dataset già sporchi o compromessi è più oneroso: meglio sbrogliare la matassa finché è ancora gestibile. I dati non si curano da soli. E se i dati di origine sono incompleti, errati o mal strutturati, può richiedere molto tempo e sforzo correggerli e migliorarne la qualità. In alcuni casi l’organizzazione può cedere alla tentazione di “accontentarsi” di una bassa qualità dei dati per non affrontare la gestione del cambiamento. Inoltre, va considerato l’aumento di entropia legato a nuovi paradigmi, architetture, infrastrutture e modelli, anche (ma non solo) legati a machine learning e AI.

Trascurare la sponsorship

Centinaia di volte indicata, in ogni continente e situazione immaginabile, come la causa principale per il fallimento dei progetti, nelle varie sfumature del “mancato allineamento” tra IT e Business o dell’assenza di supporto attivo dei top manager (“CxO level”). Per ottenere l’approvazione e il sostegno di un decision maker, in passato, il “business case” per la data quality poggiava soprattutto su esigenze esterne e impellenti, come le scadenze regolamentarie e il relativo reporting. Oggi è chiaro quanto siano diffusi, diversificati e permeati su tutta l’azienda i benefici di un presidio attivo della qualità dei dati.

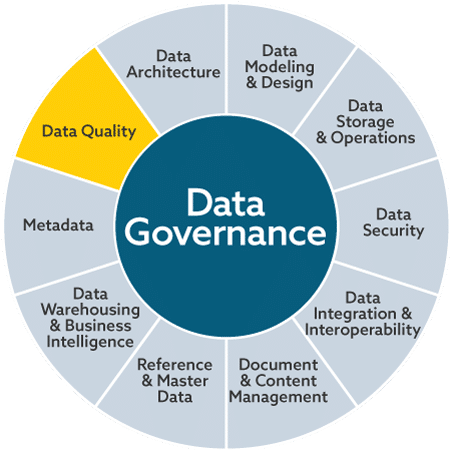

Copryright © 2017 by DAMA International

Trascurare la governance

Come si evince dalla DAMA Wheel, la data quality è soltanto uno dei 10 raggi nella grande ruota della Data Governance, assieme – tra gli altri – ai metadati, all’architettura, al design e all’integrazione e interoperabilità dei dati. Senza un corretto approccio al presidio dei dati (policy e processi adeguati e presidiati) non è possibile garantire la qualità nel tempo, né la responsabilità, l’ownership e l’accountability.

Avere la “sindrome dell’iceberg”

Il rischio di focalizzarsi solo sulla “punta” di un insieme di criticità sottostanti e meno visibili, sottolinea TDAN. I controlli più comuni (completezza, duplicazione, integrità, etc) rilevano infatti soltanto una piccola frazione dei possibili problemi, rispetto al grande “iceberg” dei rischi da gestire rispetto all’uso dei dati, prima che vengano rilevati dai clienti interni o esterni (data consumer). Viene rilevato anche un paradosso: da un lato le aziende “Fortune 1000” spendono in media 5 miliardi di dollari l’anno per garantirsi dati affidabili, dall’altro – come rilevano diverse survey Gartner, ad esempio – solo il 42% dei top manager si fida dei dati disponibili.